Dideli kalbų modeliai arba LLM yra galingas neuroninio tinklo algoritmas, skirtas kurti pokalbių robotus, kurie gauna duomenis naudodami komandas natūraliomis kalbomis. LLM leidžia mašinoms / kompiuteriams geriau suprasti natūralią kalbą ir kurti kalbą kaip žmonės. LangChain modulis taip pat veikia kuriant NLP modelius. Tačiau jis neturi savo LLM, bet leidžia bendrauti su daugeliu skirtingų LLM.

Šiame vadove bus paaiškintas sąveikos su didelių kalbų modeliais procesas naudojant „LangChain“.

Kaip bendrauti su LLM naudojant „LangChain“?

Norėdami bendrauti su LLM naudodami „LangChain“, tiesiog vadovaukitės šiuo paprastu nuosekliu vadovu su pavyzdžiais:

Įdiekite modulius, kad galėtumėte bendrauti su LLM

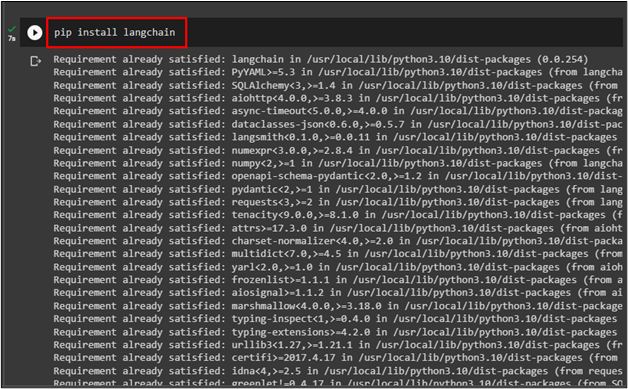

Prieš pradėdami sąveiką su LLM naudodami „LangChain“, įdiekite „ langchain “ modulis naudojant šį kodą:

pip diegti langchain

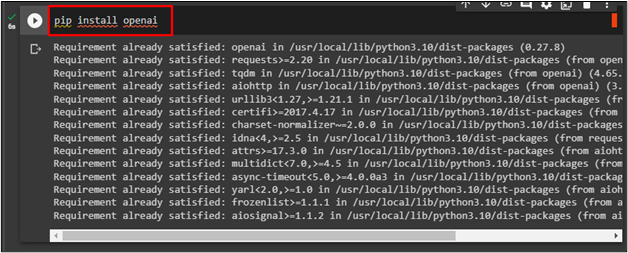

Norėdami įdiegti OpenAI sistemą, naudokite jo API raktą, kad galėtumėte bendrauti su LLM naudodami šį kodą:

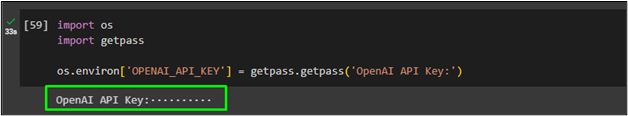

Dabar importuokite ' tu “ ir „ gauti pasą “ norėdami naudoti OpenAI API raktą po kodo vykdymo:

importuoti mus

importuoti getpass

os.aplinka [ „OPENAI_API_KEY“ ] = getpass.getpass ( „OpenAI API raktas:“ )

Skambina LLM

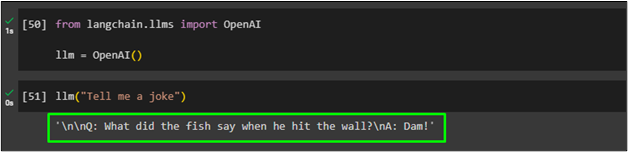

Importuokite OpenAI biblioteką iš LangChain modulio, kad priskirtumėte jos funkciją „ llm “ kintamasis:

iš langchain.llms importuoti OpenAIllm = OpenAI ( )

Po to tiesiog paskambinkite „ llm “ funkcija ir greitoji užklausa kaip jos parametras:

Sukurkite kelis tekstus naudodami LLM

Naudokite generavimo () metodą su keliais raginimais natūralia kalba, kad sugeneruotumėte tekstą iš LLM ir išsaugotumėte juos ' llm_result “ kintamasis:

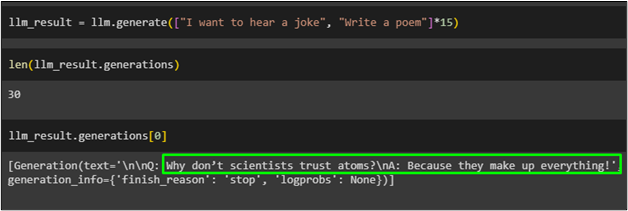

llm_result = llm.generate ( [ 'Noriu išgirsti pokštą' , 'Parašyk eilėraštį' ] * penkiolika )

Gaukite objektų, saugomų ' llm_result “ kintamasis naudojant generavimo () funkciją:

Tiesiog iškvieskite kintamąjį su objektų indekso numeriu:

Šioje ekrano kopijoje rodomas tekstas, saugomas „ llm_result “ kintamasis, kurio 0 indeksas generuoja pokštą:

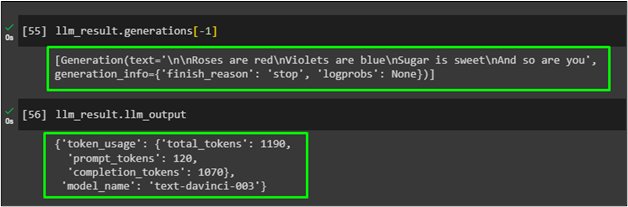

Norėdami sugeneruoti eilėraštį, patalpintą kintamajame llm_result, naudokite metodą Generations () su parametru indeksas -1:

Tiesiog parodykite sugeneruotą išvestį rezultato kintamajame, kad gautumėte konkretaus teikėjo informaciją, kuri buvo sugeneruota ankstesniame LLM naudojant sugeneruotą funkciją:

Tai viskas apie bendravimą su LLM naudojant „LangChain“ sistemą natūraliai kalbai generuoti.

Išvada

Norėdami sąveikauti su didelių kalbų modeliais naudodami „LangChain“, tiesiog įdiekite sistemas, tokias kaip „LangChain“ ir „OpenAI“, kad importuotumėte LLM bibliotekas. Po to pateikite OpenAI API raktą, kurį naudosite kaip LLM, kad suprastumėte arba sukurtumėte natūralią kalbą. Naudokite LLM įvesties raginimui natūralia kalba, tada iškvieskite jį, kad sugeneruotumėte tekstą pagal komandą. Šiame vadove paaiškintas sąveikos su didelių kalbų modeliais procesas naudojant LangChain modulius.